Es ist eine technisch optimierte Welt der webfehlerfreien Oberflächen und sanften Befehle, die den Leser_innen von Leif Randts Science-Fiction-Roman Planet Magnon (2015) kühl entgegentritt. In ihr organisieren Menschen sich in Lifestyle-Kollektiven und eine Künstliche Intelligenz namens Actual Sanity koordiniert das Zusammenleben über alle planetaren Begrenzungen hinweg. Die KI im Roman fungiert als postdemokratische Superinstanz, die den öffentlichen Verkehr ebenso regelt, wie die Vergabe von Wohnraum, jene, die sie besonders gut bewertet, brechen gleich zu Beginn des Buches zu anderen Planeten auf. Die Spitzen-Fellows des postpragmatischen Kollektivs der Dolfins unternehmen zwecks Rekrutierung neuer Mitglieder eine Reise quer durch die gesamte Galaxie und als ihr Fahrzeug mit einem frei umherlaufenden Sauropoden kollidiert, bestimmt Actual Sanity schnell und unbürokratisch über das weitere Vorgehen. »Man könnte das auch erbarmungslos nennen«, bemerkt Ich-Erzähler Marten, der eben erst Zeuge eines fragwürdigen Rettungsversuchs geworden ist: Ein von der Künstlichen Intelligenz beorderter Stoßtrupp tötet das verletzte Tier binnen Sekunden mit Stromstößen und gibt den Protagonist_innen zu verstehen, dass die wegen unterlassener Hilfeleistung verhängte Geldstrafe durch einen raschen Griff zum Wagenheber vermeidbar gewesen wäre. Der angefahrene Sauropode hätte auf diese Weise schon viel früher »erlöst« werden können.

Der Zusammenstoß mit einem fiktiven Tier konfrontiert die Leser_innen von Planet Magnon nicht einfach nur mit der Frage nach den Stellenwert des verletzten Lebens in der literarischen Galaxie von Leif Randt; vielmehr lenkt das Ereignis die Aufmerksamkeit auf einen Themenkomplex, der im Zentrum vieler Science-Fiction-Entwürfe des letzten Jahrhunderts steht. Bekanntlich war es der russisch-amerikanische Science-Fiction-Autor Isaac Asimov, der in seiner Erzählung I, Robot von 1950 die Grundzüge einer weit über das literarische Feld hinaus diskutierten Roboter-Ethik formulierte. Das Problem von in der Zukunft liegenden Handlungen, die durch die prognostischen Kräfte einer rechnenden KI antizipiert und damit bereits in der Gegenwart abgestraft werden können, taucht erstmals in Philip K. Dicks Science-Fiction-Novelle The Minority Report auf. Während die Ambivalenz ihrer technischen Erfindungen für die Pioniere der amerikanischen Science-Fiction nicht selten zum Erzählanlass wurde, nimmt Leif Randt seinem kybernetischen Steuerungssystem gegenüber eine pragmatische Haltung ein. In einem Interview nach der besseren der beiden Welten befragt, gab er zu verstehen, dass er einem gut gewarteten Actual Sanity-System den Vorzug gegenüber realweltlichen Bezügen einräumen würde.

Die Frage danach, was Maschinen »dürfen«, ist spätestens seit der Erfindung von teilautomatisierten Autos und autonomen Waffensysteme keine, die sich allein im Terrain der Science-Fiction stellt. Die Bezeichnung »Künstliche Intelligenz« (KI) ist in diesem Zusammenhang jedoch irreführend: Sie suggeriert nicht nur, dass es eine natürliche Intelligenzleistung gäbe, die nicht erst gesellschaftlich erworben worden wäre, sondern auch, dass diese Maschinen zukommen kann, die künftig vielleicht sogar die besseren Entscheidungen für Menschen treffen könnten. Der »Geist«, der in den Zählwerken der Rechner wirkt, ist hingegen einer, der über die mechanischen Gesetze der Apparate-Welt niemals hinausreichen wird. Dementsprechend bescheiden war anfangs auch das Projekt ihrer möglichen »Beseelung«: Im Gegensatz zu den sich dieser Tage verstärkt Gehör verschaffenden Propheten einer starken und damit möglichst menschenähnlichen KI wollte René Descartes seine im 17. Jahrhundert entwickelte und später für Rechenmaschinen adaptierte mathesis universalis lediglich als allgemeine Zeichenlehre verstanden wissen, mit deren Hilfe man logisches Schließen automatisieren kann.

Seit der Erfindung der Turing-Maschine ist bekannt, dass Automaten nicht reden, sondern rechnen. Demgemäß bestehen die zum Zweck ihrer Programmierung kreierten Computersprachen aus Variablen, Datentypen und Kontrollstrukturen, durch die eingespeisten Datenströme in der jeweils erwünschten Art und Weise modelliert werden können. Bei den Techniken, die dabei zur Anwendung kommen, handelt es sich keineswegs um neue Paradigmen: Beim »Machine Learning« – einem im Zusammenhang mit der Rede von »Algorithmic Intelligence« oft erwähntem Verfahren – werden für Computer adaptierte, stochastische Methoden ebenso eingesetzt wie bei der dazugehörigen Unterkategorie des »Deep Learning«. Die gängigsten Varianten des maschinellen Lernens operieren auf Basis einer der drei folgenden Typologien: Beim »Supervised Learning« wird ein bereits existierender Algorithmus auf einen neuen Datensatz angewandt, wobei die Beziehung zwischen abhängiger und unabhängiger Variable – der Wert ersterer wird dabei durch jenen der letzteren bestimmt – unter Voraussetzung des Konstant-Bleibens dieses Verhältnisses in die Höhe gerechnet wird. »Unsupervised Learning« hingegen folgt einer Logik induktiven Schließens: Ohne vorab festgelegtes Label wird ein Datensatz gruppiert und anschließend die Verteilung der Daten ermittelt. Typ drei heißt »Reinforcement Learning« und war bislang am stärksten mit der Hoffnung verknüpft, Maschinen doch noch zum Lernen zu bewegen. Dabei wird ein Muster in einem bereits vorhandenen Daten-Input nicht einfach auf einem neuen abgebildet, sondern der Algorithmus wird im Abgleich mit Ereignissen in der Systemumwelt immer wieder modifiziert.

Computare heißt zählen und zu keinem anderen Zweck wurden Computer erfunden. Selbst im Fall von sprechenden Maschinen wie Alexa oder Siri erfolgt die Modellierung eines Daten-Outputs nicht semantisch, sondern vermittels quantifizierender Codierungsverfahren. Die Antworten aus den elektrifizierten Dosen folgen dabei nicht etwa dem Prinzip der Korrelation – also der im Daten-Input bislang meistgenannten Antworten – sondern analog einer im Codierungsprozesses vorgenommenen Bewertung. Die Maschine sortiert mögliche Antworten nach Zahlen, eine Wortmeldung, die etwa mit 100 bewertet wurde, wird dabei einer anderen mit geringerer Punktezahl vorgezogen. Vom tatsächlichen Sprachverstehen weit entfernt, wird selbst die smarteste Maschine niemals wissen, was sie zur Antwort gibt: Ihre Worte sind nicht mehr als ein nach bestimmten Regeln gruppierter Daten-Output, die dazugehörigen Sortierverfahren kommen auch bei lautlosen Formen der Sprachverarbeitung zur Anwendung. Bei einer Markov-Analyse etwa wird anhand von vorhandenem Datenmaterial die jeweilige Wahrscheinlichkeit für ein Folgewort berechnet und anhand dessen die Zuordnung eines Suffixes zu einem Präfix vorgenommen. Derartige, auf wahrscheinlichkeitstheoretischen Prämissen fußende Algorithmen mögen brauchbare Hilfestellungen beim Schreiben von SMS auf Mobiltelefonen – so etwa die T9-Eingabe – liefern und sie erleichtern ebenso die Übertragung von Fließtext in gesprochene Sprache, indem sie bestimmte, darin vorkommende Wortfolgen antizipieren. Auch, dass mithilfe entsprechender Verfahren Kühlzyklen auf Basis bereits bestehender Sensordaten optimiert oder der Ausbreitungsgrad von Bakterien in einem Organismus optimal ermittelt werden kann, soll ebensowenig in Frage gestellt werden. Das Problem des maschinellen Lernens ist weniger ein funktionales, denn ein semantisches, in der Bezeichnung selbst liegt der Betrug: Maschinen lernen nicht, sie häufen an, weder gedacht noch erkannt wird in ihrem Inneren; stattdessen werden Analogien auf Basis vorhandener Muster gebildet, Unmengen an Daten, die bei der Nutzung von oft nur vermeintlich kostenfreien Online-Services anfallen, sind dafür Voraussetzung. In der Produktion dieser Daten möglichst sparsam zu sein, ist derzeit vielleicht wichtiger als den entrückten KI-Fiktionen transhumaner Propheten das Fürchten zu lehren. Die Präferenz für Letzteres resultiert jedoch nicht selten aus den jüngsten Erzählungen eines märchenhaften Tals: Technik ist im Silicon Valley weniger ein Ding denn etwas Anthropomorphes. Als sprachverarbeitendes Kind aus dieser Wiege verfügt etwa auch IBMs »Watson« über ein möglichst menschenähnliches Interface, dank »Alana« – einem beim »Amazon Alexa Prize« 2017 für die Verbesserung der Dialogqualität prämierten Konversations-Bot – wird sich künftig kaum noch jemand an den künstlichen Stimmen und sinnfreien Monologen stören. Am anderen Ende des Vocoders spricht dieser Tage eine zweite Natur und sie wird immer perfekter darin, die erste zu imitieren.

Vielleicht ist es falsche Hörigkeit oder fehlendes Wissen, vielleicht aber auch die bereits von Günther Anders ins Spiel gebrachte »prometheische Scham«, die die Spitzen-Fellows aus Leif Randts Planet Magnon vor ihrer gottgleichen KI so angewurzelt erstarren hat lassen. Die profane Welt der Algorithmen und Datenstrukturen hingegen kennt weder Divinatorisches noch Ethisches. Dass Letzteres vor allem im Zusammenhang mit Notfall-Algorithmen beim autonomen Fahren dieser Tage wieder verstärkt diskutiert wird, hat nur dem Anschein nach mit der Übermacht der Maschinen zu tun. Für ethische Dilemmata gibt es seit Aristoteles klare Regeln, die man nicht programmieren kann, sondern bestenfalls codieren – als deontologische oder utilitaristische Schwundstufen einer durchökonomisierten Gesellschaft, die sich die unmittelbare Frage nach dem richtigen Handeln gern erspart. Antastbar ist die Menschenwürde jedoch selbst dann nicht, wenn ihr Gesetzestext in Maschinensprache vorläge. Das, was Maschinen damit machten, bleibt bis auf Weiteres unzweideutig und dumm.

Actual Sanity’s Advice – Reise ins »Wunderland« der KI

Die Idee einer selbsttätigen Maschinenintelligenz hat IT-Giganten und Science-Fiction-Pioniere gleichermaßen fasziniert und manifestiert sich derzeit auch in der Rede von »Algorithmic Intelligence« und »maschinellem Lernen«. Barbara Eder über die falschen Versprechen der KI-Propheten und die profane Welt der Zeichenketten und Codes.

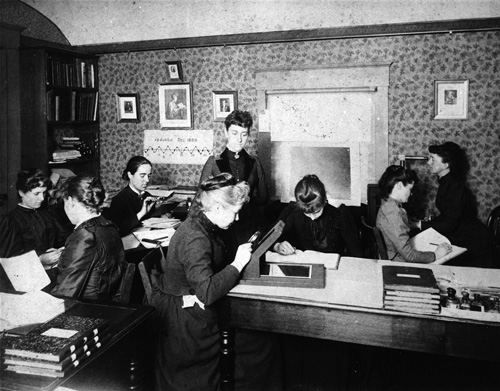

Als für Berechnungen noch (schlecht bezahlte und darum oft weibliche) Menschen benötigt wurden: »Computers« im Harvard College Observatory (ca. 1890) (Bild: Harvard College Observatory)